LG 블로그 내용을 재구성해서 정리한 내용

인공지능 분야에서 시계열(Time Series) 데이터는 일반적으로 시간 축을 갖는 테이블 형태의 데이터(Tabular Data)를 의미.본문은 AI 분야에서 시계열 문제를 해결하기 위해 다양한 노력들, 시계열 Foundation 모델에 관한 노력들에 대한 내용

1. 시계열 Foundation 모델 등장

Foundation 모델: 거대한 데이터로 사전 학습(Pre-trained)하여 다양한 문제 해결할 수 있는 가능성 지닌 모델[1]

특징: 특정 문제에만 특화된 모델이 아닌 일반화된(Generalized) 모델

자연어, 비전 등의 도메인에서 연구된 여러 Foundation 모델들이 다양한 Task에서 우수한 성능을 보임으로 가능성 有

-> 최근 시계열에서 Foundation 모델을 만들기 위한 많은 노력들 有

2. 시계열 Foundation 모델 분류

최근까지의 시계열 Foundation 모델 연구는, LLM(Large Language Model) 활용 방법론, 시계열을 위한 자체 거대 모델을 고안하는 방법론으로 분류 (그림 1).

LLM 방법론은 어떻게 거대 언어 모델을 활용하는지에 따라 1) Without Adaptation, 2) Adapt LLM, 3) Adapt to LLM 분류

자체 거대 모델 구축 연구는 거대 시계열 데이터를 수집, 다양한 시계열 데이터 학습 위한 통일된 모델링 작업으로 분류

2-1. LLM 기반 시계열 Foundation 모델

LLM으로부터 일반화된 능력을 얻어, 시계열 Foundation 모델 구축하는 것

1) Without Adaptation: LLM이 어느정도 시계열 도메인의 지식을 다양한 자연어 데이터로부터 습득했다고 가정함.

-> LLM이 시계열 도메인에 익숙해지는(Adapt) 과정이 없거나 최소화.

-> 주로 시계열 문제에 대해 어떻게 좋은 프롬프트(Prompt)를 작성할 것인지를 고민함

(예제) PrompCast는 그림 2와 같이 인풋 아웃풋 텍스트를 설계해 시계열 문제를 해결 시도.[2]

But, prompt 설계 방식 문제[3] 有. (숫자에 대한 불규칙적인 토큰화 때문)

ex) 480 토큰화 할 때, 480 하나의 토큰, 그러나 481은 48과 1로 2개의 토큰으로 만들어짐.

-> LLM이 숫자를 잘 이해할 수 있는가에 대한 의문

LLM-Time은 이 문제 해결위해, 각 숫자(Digit)를 하나의 토큰으로 표현하는 등의 시도로 시계열 문제를 LLM이 잘 이해할 수 있도록 개선함.[4]

특이점: LLM-Time은 Fine-tuning과 같은 추가적 학습 과정 없이 시계열 예측에서 좋은 성능

-> LLM-Time 논문에 따르면 이 현상은 LLM은 간단한 패턴을 파악할 수 있고, 그 간단함에 집중하여 좋은 성능을 보인 것

2) Adapt LLM: LLM은 시계열에 익숙치 않은 부분이 존재하고 익숙해지는(Adapt) 과정이 필요함을 강조(1번과 반대)

이 방법론은 보통 그림 3 형태임. LLM이 중심 모델로 자리하고, 앞뒤로 시계열 데이터와 LLM을 연결해 주는 Adaptation Layer가 존재. LLM 전체 혹은 일부와 주변 Adaptation Layer를 시계열 데이터에 Fine-tuning

-> LLM이 시계열 데이터에 익숙해질 수 있도록 함.

이 방법론의 연구에서 중요한 질문은

‘Adaptation Layer를 어떻게 설계할 것인가?’,

‘거대 언어모델을 어떻게 Fine-tuning할 것인가?’

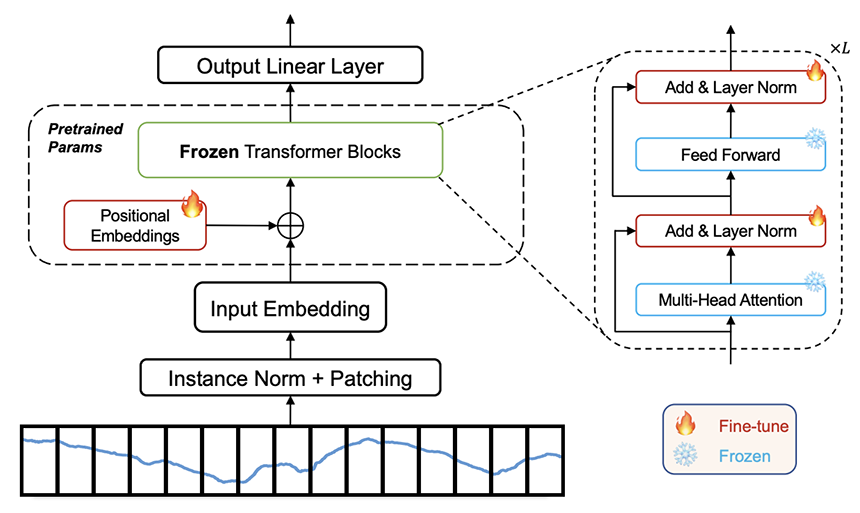

OFA는 그림 4에서처럼 Patching으로 시계열 토큰화 후 LLM 앞 뒤로 Linear Layer를 두어 모델 설계.[5]

LLM의 전체 파라미터 학습이 아닌, 일부만 학습으로 성능 향상.

논문에서 시계열 문제마다 Output Layer를 다르게 두어, 다양한 시계열 문제에 확장될 수 있음을 보임.

Ex) Output Layer가 단순 Linear 형태이면 회귀 문제 모델,

Output Layer가 Linear + Softmax 결합 형태면 분류 문제 모델

이 연구로 TEMPO는 시계열 분해를 바탕으로 Patching, LoRA (Low-Rank Adaptaion) 활용하여 성능 향상[6]

LLM4TS는 Fine-tuning 과정을 더 세분화하는 방법 제안.[7] 즉, 전반적 시계열 데이터에 익숙해지기 위한 학습 진행 후, 예측과 같은 특정 시계열 문제에 초점을 맞춰 학습하는 과정 제안.

3) Adapt to LLM: LLM이 ‘텍스트로 변환된 시계열 도메인에 대한 지식’이 있다는 것을 가정.

즉, LLM이 시계열 도메인을 이해할 수 있지만, 텍스트로 변환되었을 경우로 한정 (1번과 2번의 중간 방법)

이 방법론의 연구에서 가장 중요한 질문은 “시계열 데이터를 어떻게 텍스트로 잘 변환할 수 있을까?”

2번 방법과 차이점은 Adapt to LLM은 LLM 학습 없이 진행한다는 것

양쪽의 Fine-tuning된 Adaptation Layer가 시계열과 텍스트를 상호 변화시키고, 중간의 LLM이 텍스트로 변환된 시계열 데이터를 바탕으로 특정 Task 수행

(예제)

Time-LLM은 Cross Attention 메커니즘으로 시계열 -> 텍스트 변환 과정 명료화함.[8] 인풋 시계열 데이터를 쿼리로, 텍스트 여러 단어를 키, 밸류로 사용해 시계열 데이터를 텍스트로 매핑.

2-2. 자체 모델 기반 시계열 Foundation 모델

목표: LLM없이 Foundation 모델로서 일반화 능력을 갖기 위해 시계열을 위한 자체 거대 모델을 구축하는 것이 목표.

( 거대하면서 이질적 데이터 수용 가능한 하나의 일반화된 모델 구축)

-> 일반화된 능력을 갖출 만큼 충분한 데이터 수집 중요

수집된 데이터: 관찰 주기(Frequency) 혹은 시계열 도메인의 차이와 같은 다양한 이질성(Heterogeneity) 존재

해당 방법론의 대표적 연구로 TimeGPT[9], TimesFM[10], Moirai[11] 등이 존재. 세 방법론 모두 백억 개 이상 데이터 수집 및 이용하여 모델 학습으로 Foundation 모델 구축.

TimesFM: 검색 빈도 추이 Google Trend 데이터, Wikimedia 페이지 View수 Wiki Pageview 데이터, 그리고 간단한 시계열 패턴의 합성 데이터를 만들어 활용. 타 연구와 달리, 이 연구는 쉽게 구할 수 있는 데이터로 큰 데이터 셋 구축 및 모델 학습.

일반화된 모델 구축: 해당 방법론 연구 대부분이 1억개 이상의 파라미터를 갖는 Transformer 계열 모델 채택

TimeGPT처럼 Encoder-Decoder 계열 모델 사용, TimesFM과 Moirai처럼 Decoder-Only 계열 모델을 사용

시계열에서 일반화된 모델 구축 위해, Moirai에서는 관찰 주기(Frequency)별로 다른 Patch 크기 사용하고, 변수 랜덤 샘플링으로 다변수 시계열 문제 대응.

3. LG AI연구원의 향후 계획

시계열을 위한 Foundation 모델이 최근 활발하게 연구되지만 해당 연구가 오래 이뤄지지 않은 만큼, 많은 부분에서의 고민과 개선이 더욱 필요한 상황

LG AI연구원의 Advanced Machine Learning(AML) Lab에서는 대부분의 시계열 Foundation 모델이 다변수(Multivariate)를 고려하지 못하는 단변수(Univariate) 모델이라는 한계를 발견하고 이를 해결위한 방법 탐구 중

*** MultiCast: Zero-Shot Multivariate Time Series Forecasting Using LLMs https://arxiv.org/abs/2405.14748

논문 참조

세상의 모든 시계열은 (그 정도는 경우마다 다를 수 있지만) 모두 서로 연결됐다고 할 수 있습니다. 예를 들어, 기온이 올라가면 에어컨의 수요가 늘어나고 이는 특정 회사의 주가에 영향을 줄 수 있습니다. 일반적인 시계열 모델을 구축하고자 하는 Foundation 모델 연구는, 이렇게 모든 시계열이 서로 연관됐다는 가정을 바탕으로 탄생했다고 볼 수 있습니다.

따라서 기존에 있던 기술을 바탕으로 다변수 Foundation 모델을 구축하기 위해서는 거의 무한대에 가까운 시계열을 한꺼번에 고려해야 합니다. 하지만 이는 현재의 기술로서는 거의 불가능하기 때문에 대부분의 기존 모델들은 한 번에 하나의 시계열만 고려하는 단변수 기반의 방법론을 구축했습니다.

반면, LG AI연구원 AML Lab에서는 단변수 모델이 다변수 모델에 비해 갖는 모델 능력(Capacity) 측면의 한계를 확인하고, 시계열 개수가 무한대에 가까운 상황에서 다변수 모델로 나아가기 위한 랜덤 샘플링 방법을 제안했습니다. 무한대에 가까운 모든 시계열을 한꺼번에 고려하는 것이 아니라, 그 중 몇 개만을 랜덤하게 샘플링해서 학습하더라도 전체를 가지고 학습한 효과를 낼 수 있다는 가능성을 확인했습니다.

LG AI연구원에서는 이러한 문제 이외에도 시계열 Foundation 모델에서 해결해야할 다른 중요한 근본적인 문제들을 발견하고 이를 바탕으로 발전된 시계열 Foundation 모델을 만들기 위한 연구를 이어 나갈 예정입니다.

참고

[1] R. Bommasani et al., “On the Opportunities and Risks of Foundation Models.” arXiv, Jul. 12, 2022. doi: 10.48550/arXiv.2108.07258.

[2] H. Xue and F. D. Salim, “PromptCast: A New Prompt-based Learning Paradigm for Time Series Forecasting,” arXiv.org. Accessed: Jan. 08, 2024. [Online]. Available: https://arxiv.org/abs/2210.08964v5

[3] D. Spathis and F. Kawsar, “The first step is the hardest: Pitfalls of Representing and Tokenizing Temporal Data for Large Language Models,” arXiv.org. Accessed: Jan. 08, 2024. [Online]. Available: https://arxiv.org/abs/2309.06236v1

[4] N. Gruver, M. Finzi, S. Qiu, and A. G. Wilson, “Large Language Models Are Zero-Shot Time Series Forecasters,” arXiv.org. Accessed: Jan. 08, 2024. [Online]. Available: https://arxiv.org/abs/2310.07820v1

[5] T. Zhou, P. Niu, X. Wang, L. Sun, and R. Jin, “One Fits All:Power General Time Series Analysis by Pretrained LM,” arXiv.org. Accessed: Jan. 08, 2024. [Online]. Available: https://arxiv.org/abs/2302.11939v6

[6] D. Cao et al., “TEMPO: Prompt-based Generative Pre-trained Transformer for Time Series Forecasting,” arXiv.org. Accessed: Jan. 08, 2024. [Online]. Available: https://arxiv.org/abs/2310.04948v2

[7] C. Chang, W.-Y. Wang, W.-C. Peng, and T.-F. Chen, “LLM4TS: Aligning Pre-Trained LLMs as Data-Efficient Time-Series Forecasters,” arXiv.org. Accessed: Jan. 08, 2024. [Online]. Available: https://arxiv.org/abs/2308.08469v4

[8] M. Jin et al., “TIME-LLM: TIME SERIES FORECASTING BY REPRO- GRAMMING LARGE LANGUAGE MODELS”.

[9] A. Garza and M. Mergenthaler-Canseco, “TimeGPT-1.” arXiv, Oct. 05, 2023. Accessed: Feb. 14, 2024. [Online]. Available: http://arxiv.org/abs/2310.03589

[10] A. Das, W. Kong, R. Sen, and Y. Zhou, “A decoder-only foundation model for time-series forecasting.” arXiv, Feb. 04, 2024. Accessed: Feb. 13, 2024. [Online]. Available: http://arxiv.org/abs/2310.10688

[11] G. Woo, C. Liu, A. Kumar, C. Xiong, S. Savarese, and D. Sahoo, “Unified Training of Universal Time Series Forecasting Transformers.” arXiv, Feb. 04, 2024. Accessed: Feb. 13, 2024. [Online]. Available: http://arxiv.org/abs/2402.02592

'TechStudy > TimeSeries' 카테고리의 다른 글

| Recurrent Neural Networks for Multivariate Time Series With Missing Values(2016) (0) | 2024.10.16 |

|---|---|

| Time Series Forecasting With Deep Learning A Survey(2020) (2) | 2024.10.15 |

| [펌] 딥러닝 기반 시계열 예측(Time Series Forecasting) 모델 동향 (~2022) (1) | 2024.10.14 |

| ICLR 2024 학회 (LG 블로그 요약) (4) | 2024.10.14 |

| 기본 개념 (0) | 2024.10.10 |